Jak odhalit deepfake? Posviťte si na to

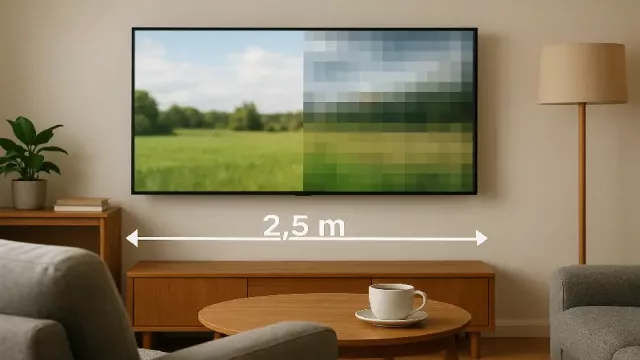

Představte si, že během natáčení videa je přímo do osvětlení scény – například světel z reflektorů nebo jevištního osvětlení – zakódována neviditelná informace. Každé originální video dostane unikátní, okem nepostřehnutelný světelný podpis, který bude trvale zakódovaný v každém jeho snímku. Jakmile by ale někdo video upravil umělou inteligencí, tento kód by se poškodil nebo úplně zmizel. Jeho pravost se pak dá jednoduše ověřit analýzou – stačí zkontrolovat, jestli v něm skrytý světelný podpis stále je.

Tato metoda funguje trochu jako vodoznak, jen je ukrytá ve světle, a je ideální hlavně pro média a novináře. Výrazně jim totiž pomáhá v boji proti dezinformacím. Díky tomu mohou snadno ověřit, jestli s videem nebylo manipulováno.

Od anomálií v obraze po analýzu stínů

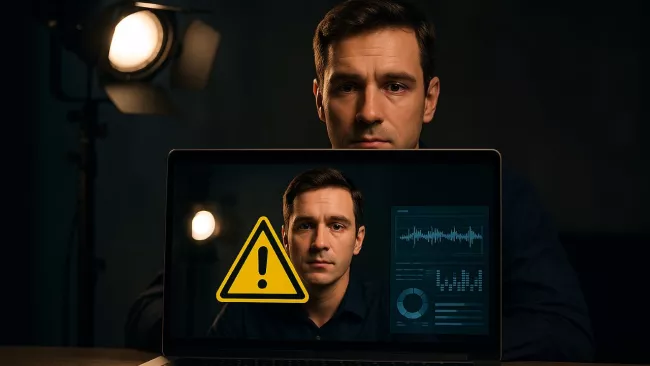

Nejčastější metodou, jak dnes odhalit deepfake, je využití hlubokých neuronových sítí. Tyto systémy se trénují na rozpoznávání jemných nesrovnalostí v obraze i zvuku, kterých si lidské oko a ucho často nevšimne. Běžně se zaměřují na detaily, jako je zvláštní textura kůže, chybějící odlesky v očích, nebo nesoulad mezi tím, jak se pohybují rty, a tím, co zazní ve zvukové stopě. Ty nejlepší systémy dokonce vyhodnocují obraz i zvuk najednou, což výrazně zvyšuje šanci na odhalení podvrhu.

Problém ale je, že nejnovější generace umělé inteligence – třeba model Veo od Googlu – už dokáže vytvořit tak realistická videa, že obyčejný člověk nemá šanci poznat rozdíl. Z tohoto důvodu se výzkum zaměřuje na pokročilejší metody. Jedna z nich je analýza konzistence osvětlení v jediném záběru.

Pokud umělá inteligence do videa vkládá nový, uměle vytvořený prvek, často se jí nedaří dokonale sladit stíny a světelné zdroje v celém snímku. Speciální neuronové sítě jsou schopny tyto nepatrné nesrovnalosti v nasvícení odhalit a tím deepfake usvědčit.

Proč je odhalování deepfake videí tak složité?

Boj proti deepfake obsahu připomíná neustálý závod ve zbrojení. Generativní modely se zdokonalují tak rychle, že vytvářejí podvrhy téměř bez chyb. Detekční algoritmy je tak často odhalí jen stěží. Klasické digitální vodotisky, které se do videa vkládají čistě softwarově, navíc nejsou spolehlivé – lze je z nahrávky odstranit, nebo naopak do falešného videa dodatečně přidat. Další překážkou je, že chytré detektory potřebují pro své učení obrovské množství dat, což je technicky i finančně velmi náročné.

Právě proto je kódování světelného vodotisku přímo při natáčení videa považováno za mnohem robustnější řešení. Takový podpis je fyzickou součástí záznamu a jakákoli změna obsahu způsobí, že světelný kód přestane dávat smysl.

Budoucnost důvěry ve videoobsah

Technologický rozvoj deepfake videí neustále posouvá hranice toho, co vnímáme jako realitu. Zároveň nás ale nutí hledat nové a spolehlivější způsoby, jak ověřovat pravost obsahu. Skrývání informací přímo do světla při natáčení se ukazuje jako jedna z nejslibnějších cest, jak chránit integritu videozáznamů.

Klíčové to je zejména v oblastech, kde se na pravost obsahu klade velký důraz. Jde například o zpravodajství nebo důkazní materiály u soudu. Kombinace těchto hardwarových technik s pokročilými AI detektory dává reálnou naději, že si důvěru ve videoobsah udržíme i v digitálním věku, plném dezinformací.

Zdroj: Cornell University News, TechXplore, arxiv.org, Springer, Reality Defender