Obnažovací deep fake – od výměny tváří po plně generované obrazy

Zneužívání tzv. nekonsenzuálních intimních snímků (NCII) se objevilo poprvé v roce 2017, kdy se na internetu objevilo falešné video s herečkou Gal Gadot. Právě tehdy vznikl pojem „deepfake“. Od té doby prošla technologie prudkým vývojem – od jednoduchého prohazování obličejů až po dnešní systémy založené na pokročilých neuronových sítích typu GAN, které dokážou vytvářet zcela nové, velmi přesvědčivé obrazy.

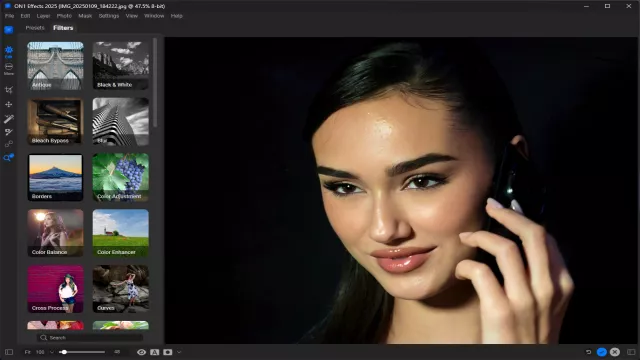

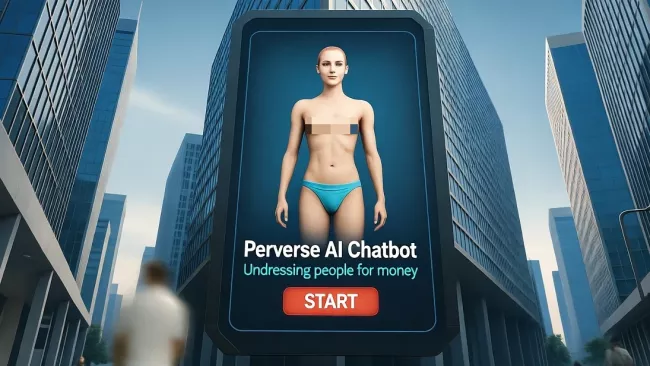

Paradoxně však většina botů na Telegramu nepoužívá tyto nejmodernější metody. Často jde jen o nástroje, které ze zaslaných fotografií digitálně „odstraňují“ oblečení. Takové služby se přitom staly výnosným byznysem: uživatelé platí pomocí virtuálních tokenů, zatímco část podvodníků provozuje nefunkční nebo nebezpečné kopie.

Rizika pro soukromí i etiku

Používání podobných botů není jen neetické, ale i nebezpečné. Výsledek není zaručený a uživatelé často přicházejí o kontrolu nad svými daty. Úniky citlivých informací – například z projektů jako AI Girlfriend – ukazují, jak snadno mohou takové systémy zneužít soukromé materiály nebo rozšířit malware.

Odborníci varují, že deep faky mohou mít závažné dopady, zejména na ženy. Italští výzkumníci označují tvorbu intimních deep fake snímků bez souhlasu za novou formu sexuálního násilí s dlouhodobými psychickými následky.

Riziko je obří, protože tímto způsobem může být zneužita prakticky jakákoliv fotografie: snímek, který umístí na sítě vaše dcera, fotka vaší ženy ze svatby a podobně.

Snaha o regulaci

Některé země se už pokoušejí situaci řešit. V USA byl předložen návrh zákona o odpovědnosti za deep faky (Deep fake Accountability Act) a platformy jako Google zavedly zákaz šíření nevyžádaného syntetického pornografického obsahu ve výsledcích vyhledávání. Zatím to ale nestačí – trh s nelegálními deepfaky dál roste, hlavně na Telegramu, jak bylo zmíněno.

Co zvážit před sdílením fotografií

Když nahráváte fotografie na sociální sítě, často tím dáváte umělé inteligenci přístup k datům, která lze později zneužít. Obrázky mohou sloužit k trénování modelů nebo ke tvorbě deepfake materiálů, které poškodí vaši pověst či naruší soukromí.

Kromě toho většina snímků obsahuje metadata s přesnou polohou pořízení, a jakmile se jednou dostanou na internet, je prakticky nemožné je úplně odstranit. Přidat se k tomu mohou i otázky autorských práv či předpojatosti algoritmů.

Proto je dobré přemýšlet, co zveřejňujete – nejen kvůli sobě, ale i kvůli ostatním. Internet má totiž dlouhou paměť a umělá inteligence se z něj učí víc, než si většina lidí uvědomuje.

Zdroj: Malwarebytes (1), Malwarebytes (2), Reuters, Wired