Vynutil si přístup k ChatGPT

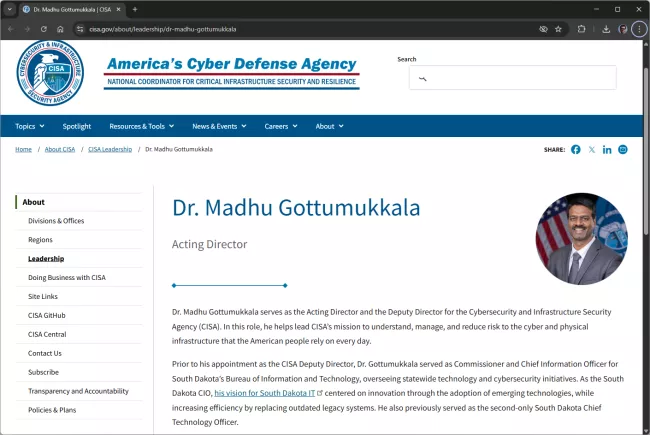

V srpnu 2025 zachytily bezpečnostní senzory CISA (Agentury pro kybernetickou bezpečnost a zabezpečení infrastruktury) několik podezřelých nahrání dokumentů. Gottumukkala, dočasný ředitel CISA, totiž nahrál do ChatGPT smluvní dokumenty označené jako "pouze pro služební účely". Šlo tedy o kategorii, která sice není nejvyšším stupněm utajení, ale znamená, že data nejsou určena pro veřejnost.

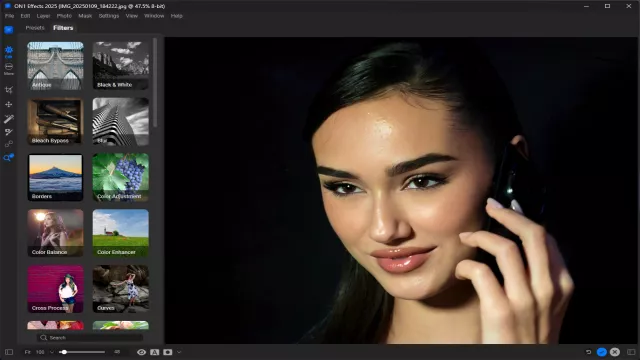

To, co celou záležitost dělá ještě absurdnější, je fakt, že Gottumukkala si musel vyžádat speciální povolení k používání ChatGPT. Zatímco ostatní zaměstnanci ministerstva vnitřní bezpečnosti měli přístup k této službě blokovaný, on si prosadil výjimku.

Jeden z úředníků to později popsal slovy, že Gottumukkala "donutil CISA, aby mu ChatGPT zpřístupnila, a pak toho zneužil." Podle vyjádření tiskové mluvčí CISA Marci McCarthy bylo používání ChatGPT "krátkodobé a omezené" a proběhlo pod kontrolou. Agentura však zároveň potvrdila, že standardně je přístup k ChatGPT blokován, pokud není udělena výjimka.

Proč je chování šéfa CISA problém?

Když nahrajete něco do veřejné verze ChatGPT, nesdílíte to jen s umělou inteligencí, ale předáváte data firmě OpenAI. Ta je může použít k trénování svých modelů, což v praxi znamená, že informace potenciálně mohou být zpřístupněny komukoli z více než 700 milionů aktivních uživatelů aplikace.

Na rozdíl od bezpečných vládních nástrojů, jako je DHSChat, který má americká vláda pro interní použití, veřejný ChatGPT neumožňuje kontrolu nad tím, kam se data dostanou. To je zásadní rozdíl. Interní nástroje jsou konfigurovány tak, aby dokumenty a dotazy neopustily vládní sítě.

OpenAI sice nabízí firemní verze ChatGPT s lepší ochranou dat, kde jsou informace zpracovávány bez toho, aby se použily k trénování modelů, ale Gottumukkala používal běžnou veřejnou verzi. A to je právě kámen úrazu.

Mohlo by vás zajímat

Co byste do ChatuGPT nikdy neměli psát: je to past, která vás může stát soukromí i peníze

Jak ChatGPT nakládá s daty?

Pochopení toho, jak ChatGPT zachází s nahranými daty, je důležité pro každého, kdo zvažuje použití této technologie v profesním prostředí. Základní pravidlo je jednoduché: cokoliv nahrajete do bezplatné nebo standardní verze ChatGPT, může být použito k vylepšení modelů AI.

Uživatelé sice mohou vypnout trénování na svých datech v nastavení, ale to platí jen do budoucna. Data už nahraná zůstávají v systému. Po smazání konverzace jsou údaje odstraněny z hlavního úložiště do 30 dnů, ale mohou být uchovávány déle, pokud to vyžaduje zákon nebo bezpečnostní důvody.

Pro firmy a organizace existují placené verze ChatGPT Enterprise nebo Business, kde OpenAI standardně nepoužívá firemní data k trénování. Ale i zde platí, že organizace musí mít jasné interní směrnice, co smí a nesmí zaměstnanci do AI nástrojů nahrávat.

Mohlo by vás zajímat

Lokální instalace GPT

Obecná rizika použití AI nástrojů pro citlivá data

Incident s CISA není ojedinělý. Stále více organizací se potýká s otázkou, jak bezpečně používat generativní AI, aniž by ohrozily důvěrné informace. AI nástroje jsou užitečné: pomáhají s analýzou dokumentů, tvorbou textů, programováním. Proto je lákavé a zároveň problematické je používat i pro citlivé projekty.

Hlavní rizika zahrnují:

- Úniky dat: Jakmile nahrajete dokument do veřejného AI nástroje, ztratíte nad ním kontrolu. I když výrobce tvrdí, že data chrání, jsou uložena na jeho serverech a mohou být předmětem právních žádostí, hackerských útoků nebo chyb v zabezpečení.

- Trénování modelů: Vaše citlivé informace se mohou stát součástí trénovacích dat, což znamená, že AI by je mohla teoreticky použít při odpovídání jiným uživatelům. Byť je pravděpodobnost přesného reprodukování nízká, riziko tu je.

- Nedostatek šifrování a kontroly: Na rozdíl od specializovaných vládních nebo firemních systémů veřejné AI nástroje nenabízejí stejnou úroveň zabezpečení. Chybí jim funkce jako šifrování s vlastními klíči nebo možnost určit geografickou lokaci, kde se data ukládají.

- Právní a regulatorní rizika: V Evropské unii GDPR vyžaduje zvláštní opatření při zpracování osobních údajů prostřednictvím AI. Organizace musí být schopny vysvětlit, jak AI s daty nakládá, a zaručit práva jednotlivců na opravu nebo výmaz informací.

- Agregace informací: I když jednotlivé části informací sami o sobě nejsou citlivé, AI modely jsou schopny je spojovat a vytvářet nové poznatky. To znamená, že nahrání několika zdánlivě neškodných dokumentů může vést k odhalení citlivějších souvislostí.

Jak se můžete chránit?

Pro organizace i jednotlivce platí podobná pravidla. Především nikdy do veřejných AI nástrojů nenahrávejte nic, co by nemělo být veřejné. To zahrnuje:

- Osobní údaje zaměstnanců, zákazníků nebo partnerů

- Obchodní tajemství a strategické dokumenty

- Finanční informace a smlouvy

- Interní komunikaci a dokumenty označené jako důvěrné

- Jakékoliv informace podléhající regulatorním požadavkům na ochranu

Místo veřejných nástrojů by organizace měly používat firemní verze AI služeb s odpovídajícími bezpečnostními zárukami. Pokud takové možnosti nemají, měly by zvážit vlastní nasazení AI modelů nebo využívat specializované nástroje, kde mají kontrolu nad daty.

Důležité je také školení zaměstnanců. Mnoho úniků se neděje kvůli zlému úmyslu, ale prostě proto, že lidé nevědí, jaká rizika jejich jednání přináší. Jasné interní směrnice o tom, co lze a nelze dělat s AI nástroji, jsou nezbytné.

Zdroj: Politico, TC, Ars Technica, Independent